Los periodistas Bianca Pallaro (The New York Times), Ignacio Ferreiro (Chequeado) y Florencia Coelho (La Nación) compartieron sus experiencias y recomendaciones sobre el periodismo de datos, en el XIII Encuentro del Consejo Latinoamericano de Acreditación de Educación en Periodismo y Comunicación (CLAEP).

Los expertos coincidieron que la finalidad de trabajar con datos es “descubrir y contar historias relevantes” durante el encuentro realizado en la Universidad Católica Argentina (UCA), bajo el lema “Kit de emergencia para reinventar la comunicación”. El panel moderado por el periodista y docente Martín Duré enfatizó en la necesidad de la supervisión humana, el juicio periodístico y las consideraciones éticas debido al margen de error o sesgos de la tecnología utilizadas en el procesamiento y análisis de datos.

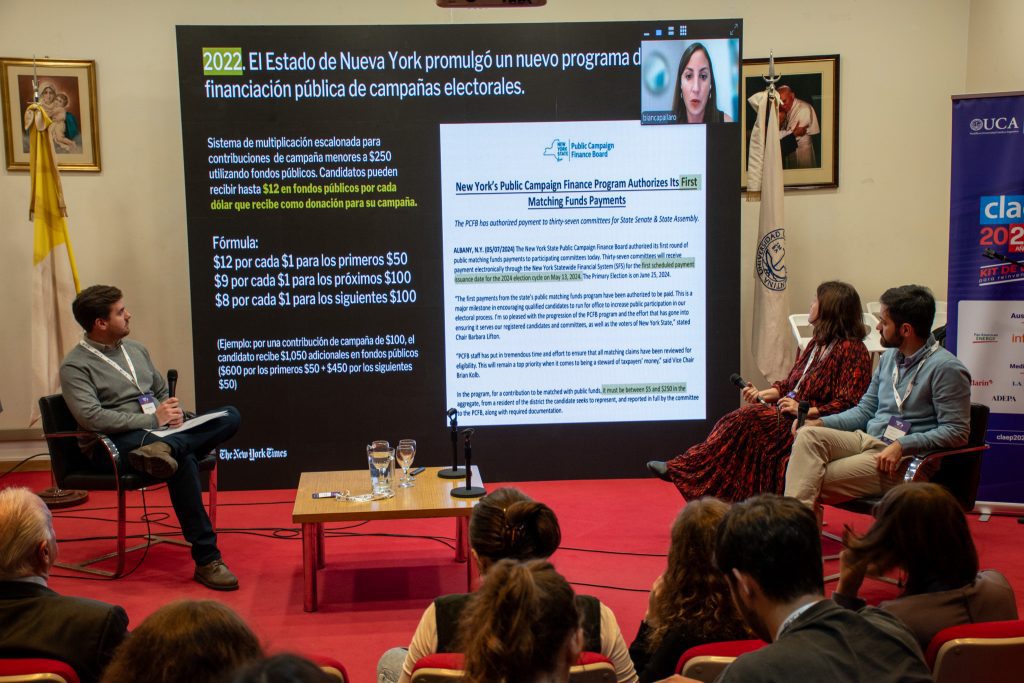

Pallaro habló de una investigación que realizó el año pasado sobre un nuevo programa de financiamiento de campaña con fondos públicos implementado por primera vez a nivel estatal en Nueva York, donde donaciones menores a 250 dólares eran multiplicadas con fondos públicos. Para realizar el artículo, contó que tuvo que solicitar informes gubernamentales y procesar esos datos hasta encontrar una historia. “En toda base de datos hay una historia y es verdad que a veces es muy difícil y quizás la historia es irrelevante a nivel periodístico, pero hay una historia”, destacó.

La investigación se enriqueció con solicitudes de acceso a la información pública y el uso de Google Pinpoint para procesar comprobantes manuscritos de donaciones. “Usamos un sistema de OCR para convertirlos a hojas de cálculos, muchas herramientas disponibles gratuitas como Tabula o Small PDF, yo uso mucho la librería pdfplumber de Python”.

Además, contó que el análisis de datos requiere metodología rigurosa. Es clave medir su evolución, profundizar en detalles, comparar variables, examinar segmentos y detectar anomalías. La periodista destacó que, aunque las herramientas fueron esenciales, el reporteo tradicional resultó indispensable para recolectar información casa por casa y hablar con las personas y organizaciones involucradas.

“Apenas salió la investigación, esto impulsó a la entidad a adoptar una resolución de emergencia para endurecer sus normas y y prevenir futuros abusos y después al mes que publicamos, el FBI abrió una pesquisa oficial que actualmente se encuentra en curso para investigar al candidato”, explicó.

Ferreiro habló que el objetivo de Chequeado es facilitar que las personas tomen decisiones informadas. Para esto, utilizan gráficos porque ayudan a la interpretación de datos, desde discursos públicos hasta la eficiencia del transporte. “En Chequeado hacemos gráficos para mitigar los efectos de la desinformación porque básicamente convencen, tienen un poder de convencer a la gente, de cambiar como la gente piensa”, aseguró.

El coordinador de datos explicó que la IA les permite procesar grandes volúmenes de texto que parecen ser inabarcables para un humano, como el Boletín Oficial, e identificar detalles clave. Ferreiro resaltó que poner a las personas en el centro de las historias basadas en datos maximiza el impacto y que presentar la información de forma accesible es esencial para un mayor entendimiento.

También subrayó el valor de los pedidos de acceso a la información pública como fuente clave para el periodismo. Son una herramienta prolífica y lo más parecido a una primicia en el mundo de los datos. Aunque a veces hay dificultades con la disponibilidad de datos, eso no disminuye la calidad del pedido como herramienta para buscar la información. Y agregó: “Uno de los usos de las bases de datos en nuestro día a día es el periodismo de datos para verificar el discurso público”.

Coelho de La Nación habló de que la IA, basada en estadísticas, opera con márgenes de error, lo que exige un uso responsable en el periodismo. Por eso, destaca que el proceso de Human in the loop fue indispensable en el trabajo que realizó La Nación de análisis de los telegramas electorales en 2021, en los cuales querían detectar posibles insistencias o errores.

“Siempre vas a tener un margen de error pero sino no harías el proyecto. A veces la capacidad de escalar tu capacidad de trabajo es mucho más importante que sea fidedigno en el 100% de los casos, a veces un error sale más barato que que no poder hacer la nota”, reflexionó.

La gerente de investigación contó que además para minimizar errores, se pueden comparar resultados de distintos buscadores de IA, como otra de las posibilidades presentadas para detectar sesgos e inconsistencias. “Lo que hay que tener mucho cuidado es que tiene sesgos… tiene errores, divaga y, a veces, inventa y hay problemas eventualmente de copyright”, remarcó.

Esta conferencia reafirmó el valor de contar historias con datos, para hacerlo se necesitan herramientas tecnológicas y metodológicas. Las historias pueden ser de gran variedad, pero siempre los datos deben ser accesibles y contar con un control exhaustivo detrás.